En un avance que podría transformar la interacción entre humanos y robots, ingenieros de la Universidad de Columbia han creado Emo, un rostro robótico revestido de silicona que no solo establece contacto visual sino que también utiliza dos modelos de inteligencia artificial (IA) para anticipar y replicar la sonrisa de una persona antes de que esta sonría. Este desarrollo representa un progreso mayor en la capacidad de los robots para predecir con precisión las expresiones faciales humanas, mejorando las interacciones y construyendo confianza entre humanos y máquinas.

La comunicación no verbal, especialmente las expresiones faciales, ha sido un desafío persistente en el diseño de robots capaces de interactuar de manera natural con los humanos. Emo, desarrollado por el Creative Machines Lab de Columbia Engineering, supera este obstáculo al anticipar las expresiones faciales y ejecutarlas simultáneamente con una persona. Ha aprendido a predecir una sonrisa inminente aproximadamente 840 milisegundos antes de que la persona sonría, co-expresando la sonrisa simultáneamente.

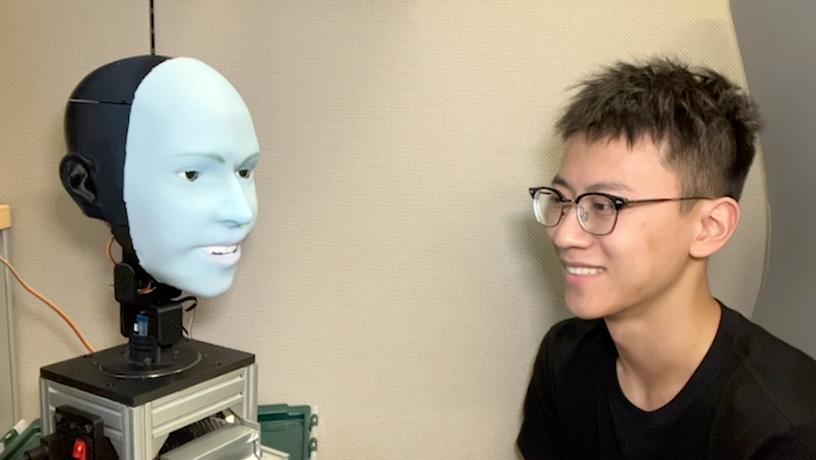

Emo es una cabeza de aspecto humano con un rostro equipado con 26 actuadores que permiten una amplia gama de expresiones faciales matizadas. La cabeza está cubierta con una piel de silicona suave, facilitando la personalización y el mantenimiento rápido. Para interacciones más realistas, los investigadores integraron cámaras de alta resolución dentro del pupilo de cada ojo, permitiendo a Emo establecer contacto visual, crucial para la comunicación no verbal.

Ingenieros de Columbia desarrollan Emo, un rostro robótico capaz de anticipar y replicar la sonrisa humana antes de que ocurra, marcando un avance significativo en la predicción de expresiones faciales humanas.

El equipo desarrolló dos modelos de IA: uno que predice las expresiones faciales humanas analizando cambios sutiles en el rostro objetivo y otro que genera comandos de motor utilizando las expresiones faciales correspondientes. Para entrenar a Emo en cómo hacer expresiones faciales, los investigadores lo colocaron frente a la cámara y le permitieron realizar movimientos aleatorios. Después de unas horas, el robot aprendió la relación entre sus expresiones faciales y los comandos de motor, un proceso que el equipo denomina «auto modelado».

Los investigadores ahora trabajan para integrar la comunicación verbal, utilizando un modelo de lenguaje grande como ChatGPT, en Emo. A medida que los robots se vuelven más capaces de comportarse como humanos, Hod Lipson, líder del proyecto, es consciente de las consideraciones éticas asociadas con esta nueva tecnología. «Aunque esta capacidad anuncia una plétora de aplicaciones positivas, desde asistentes domésticos hasta ayudas educativas, es fundamental que los desarrolladores y usuarios ejerzan prudencia y consideraciones éticas», afirma Lipson.

El desarrollo de Emo por parte de los ingenieros de Columbia no solo demuestra la capacidad real y potencialmente superior de la IA en la predicción de expresiones faciales humanas, sino que también anticipa una era en la que su integración en el equipo médico podría mejorar significativamente la calidad y la experiencia de la atención médica. Al avanzar en robots que pueden interpretar y mimetizar con precisión las expresiones humanas, nos acercamos a un futuro donde interactuar con un robot se sienta tan natural y cómodo como hablar con un amigo.

Toda revolución necesita sus cronistas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.