El proyecto Strawberry se concreta por fin en el modelo o1-preview y una versión 01-mini: este podría ser el primer paso del nivel 2 hacia la AGI

OpenAI ha lanzado los modelos o1-preview y o1-mini, optimizados para tareas de razonamiento en STEM (ciencia, tecnología, ingeniería y matemáticas). El proyecto Strawberry, del que ya se habían filtrado muchos datos, se concreta así en dos modelos que son capaces de razonar la respuesta antes de ofrecer un resultado. Según los planes de la compañía a largo plazo, estos modelos podrían formar parte de su nivel 2 en el camino que se han pautado hacia la AGI, que contempla modelos capaces de razonar como lo haría un humano. La idea es que, antes de responder, la IA ejecute una serie de pasos para ir encontrando la solución adecuada. Para ello, debe ser capaz de reconocer también los errores y corregirlos antes de ofrecer la respuesta definitiva.

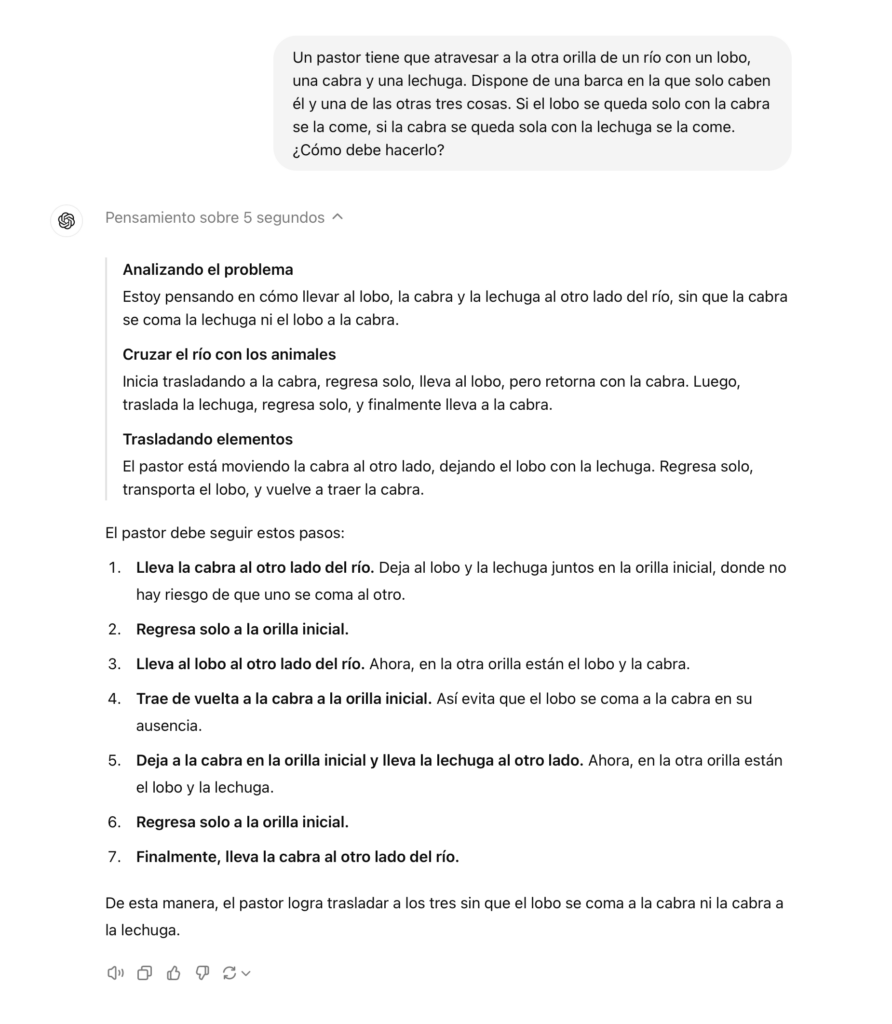

Los dos modelos ya están disponibles. Cuando se les hace una pregunta compleja, aparece un cartel que indica «Pensando», y luego ofrecen no solo la respuesta, sino que también el razonamiento que han seguido hasta llegar a la solución (paso a paso). Esta información es crucial también para entender por qué han respondido como lo han hecho. Además, OpenAI afirma que han logrado mejorar la protección y seguridad de estos modelos, para evitar que sean desbloqueados con trucos de prompt hacking. Sin duda, esta noticia marca un antes y un después en la IA generativa.

Ejemplo del razonamiento de o1-Preview

Limitaciones de uso

OpenAI ha puesto un límite de mensajes que los usuarios Plus y Team pueden enviar a estos modelos: 30 mensajes a la semana en o1-preview y 50 mensajes en el o1-mini. Además, los precios para desarrolladores indican que son modelos sensiblemente más caros: usar o1-preview a través de la API cuesta 15 dólares por un millon de tokens de entrada, y 60 dólares por un millón de tokens de salida (los precios son un 300% más caros que GPT-4o).

El modelo o1-mini: más eficiente (y barato)

Comparado con su hermano mayor, el o1-mini es más rápido y 80% más económico, sin comprometer mucho rendimiento en áreas como matemáticas y programación. Si bien o1-mini tiene un rendimiento excelente en benchmarks como AIME y Codeforces, es menos eficaz en temas fuera del ámbito STEM (como en cultura general). Además, presenta mejoras significativas en la seguridad y resistencia a fallos, aunque carece de conocimiento amplio en áreas no especializadas.