Groq, una empresa emergente en el campo de los chips de inteligencia artificial, ha irrumpido en el escenario tecnológico con una propuesta que promete cambiar las reglas del juego en la generación de texto mediante IA. Con su innovadora Unidad de Procesamiento de Lenguaje (LPU), Groq ha demostrado capacidades de inferencia ultrarrápidas, posicionándose como la IA generativa de texto más rápida hasta la fecha.

La distinción entre las cargas de trabajo de formación e inferencia en IA es crucial para entender el avance que Groq representa. Mientras que la formación de modelos de IA demanda una gran capacidad informática y de memoria, la inferencia —el proceso por el cual el modelo responde a consultas— requiere velocidad. Aquí es donde Groq brilla, ofreciendo respuestas a un ritmo sin precedentes, lo que permite una interacción más fluida y natural con los modelos de lenguaje.

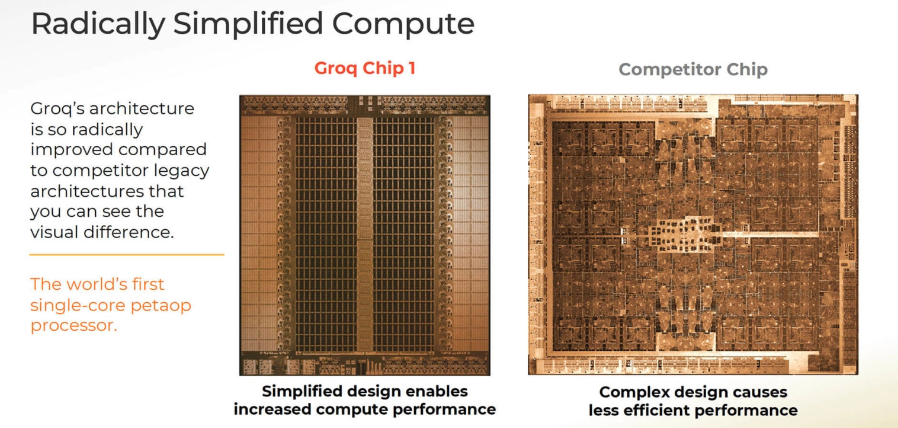

La arquitectura LPU de Groq, a diferencia de las tradicionales GPU, está específicamente diseñada para ejecutar Grandes Modelos de Lenguaje (LLM) como GPT, Llama y Mistral LLM. Esta especialización se traduce en una generación de texto significativamente más rápida, con pruebas comparativas que muestran velocidades de hasta 500 tokens por segundo, frente a los 30-50 tokens por segundo de modelos como GPT 3.5.

Este avance no solo representa un hito técnico, sino que también plantea un desafío directo a gigantes como Nvidia, que hasta ahora han dominado el mercado de hardware para IA con sus potentes GPUs. La eficiencia y velocidad de las LPUs de Groq podrían ofrecer una alternativa viable y más especializada para la ejecución de LLMs.

La promesa de Groq va más allá de la mera velocidad; implica una transformación en la forma en que interactuamos con la inteligencia artificial. Las aplicaciones prácticas de una IA generativa más rápida son vastas, desde la mejora de asistentes virtuales hasta la creación de contenido en tiempo real. La capacidad de mantener conversaciones naturales con una IA, sin las pausas y retrasos que caracterizan a los modelos actuales, podría revolucionar la experiencia del usuario.

Aunque Groq aún no ofrece sus chips directamente a consumidores finales, su tecnología ya está siendo integrada por empresas que buscan aprovechar esta velocidad de cálculo en sus servicios en la nube. Este enfoque B2B inicial sugiere que pronto podríamos ver chatbots y otros servicios basados en IA que utilicen la tecnología de Groq, ofreciendo experiencias de usuario significativamente mejoradas.

La aparición de Groq en el panorama de la IA no solo es una demostración de innovación tecnológica, sino también un recordatorio de la constante evolución y competencia en el sector. Con cada avance, se abren nuevas posibilidades para el desarrollo y aplicación de la inteligencia artificial, marcando el comienzo de una era donde la velocidad y eficiencia de la generación de texto por IA alcanzan niveles nunca antes vistos.

Alucina con Paréntesis. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.