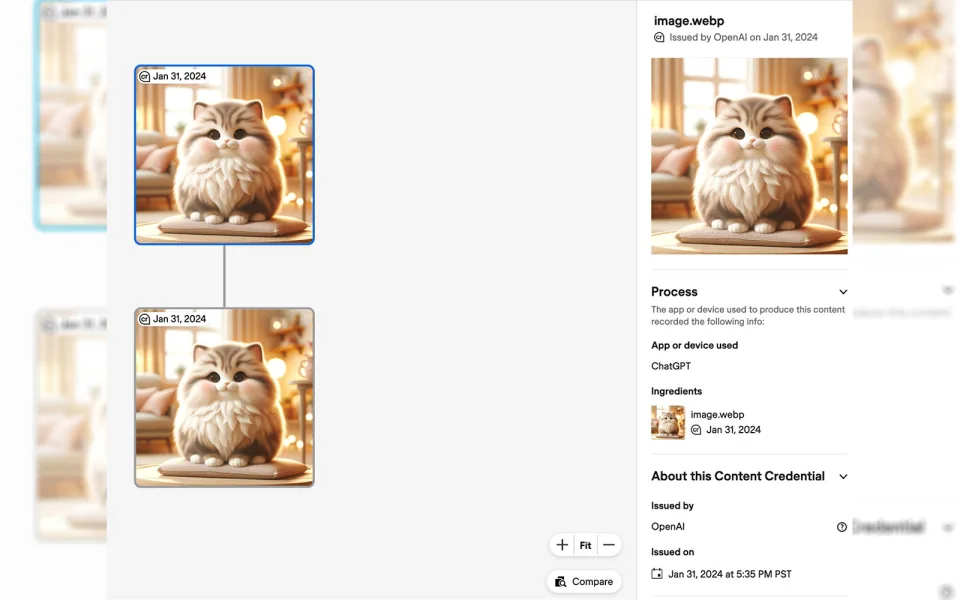

OpenAI ha anunciado la incorporación de nuevas marcas de agua digitales en las imágenes generadas por DALL-E 3. En una publicación de blog reciente, la compañía informó que se agregarían marcas de agua de la Coalición para la Procedencia y Autenticidad del Contenido (C2PA) a las imágenes generadas por IA. OpenAI cree que la adopción de esta marca de agua ayudará a aumentar la confianza pública en la información digital.

Los usuarios pueden verificar si una imagen ha sido generada por IA utilizando sitios como Content Credentials Verify. OpenAI señaló que algunas organizaciones de medios también están utilizando este estándar para verificar la fuente del contenido. Sin embargo, OpenAI reconoció que el método no es una solución perfecta, ya que la marca de agua podría eliminarse fácilmente.

La preocupación por la propagación de la desinformación, especialmente el contenido generado por IA como audio, imágenes y videos, ha ido en aumento en el contexto de las próximas elecciones. A medida que miles de millones de personas se preparan para votar este año, ya se han encontrado problemas con contenido generado por IA, incluyendo llamadas automáticas que imitan a Joe Biden y anuncios de video falsos de Rishi Sunak. Los deepfakes explícitos de Taylor Swift también acapararon titulares el mes pasado, provocando condenas internacionales y acciones legislativas.

La compañía tecnológica Meta también ha indicado que se está preparando para tomar medidas enérgicas contra la propagación de contenido generado por IA. La compañía anunció el martes que planea adjuntar etiquetas a las imágenes generadas por IA en Facebook, Instagram y Threads.

OpenAI es consciente de que los planes no son perfectos. La compañía dijo que C2PA ya se incluye en los metadatos de las imágenes producidas con la versión web de DALL·E 3 y planea extender esto a los usuarios móviles para el 12 de febrero. Sin embargo, OpenAI señaló que los metadatos no son «una bala de plata para abordar problemas de procedencia», ya que podrían eliminarse fácilmente, ya sea accidentalmente o intencionalmente.

Marcar el contenido generado por IA ha sido un desafío en general. Los estudios han encontrado que la mayoría de las formas de marca de agua digital tienen debilidades que los actores maliciosos pueden aprovechar fácilmente. Los intentos iniciales de proporcionar sistemas para verificar el contenido escrito en busca de signos de IA también han resultado relativamente infructuosos. OpenAI retiró discretamente su servicio de detección debido a preocupaciones sobre su precisión.

IA inesperadamente amena. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.